稀疏自编码器

自编码器

传统反向传播神经网络缺点:

- 梯度越来越稀疏(梯度弥散):从顶层越往下,误差校正信号越来越小;

- 容易收敛到局部最小值,尤其是从远离最优区域开始的时候(将参数初始化为随机值会导致这种情况发生);

- 只能进行有监督训练,但大部分的数据是没有标签的,而人类的大脑可以从没有标签的数据中学习。

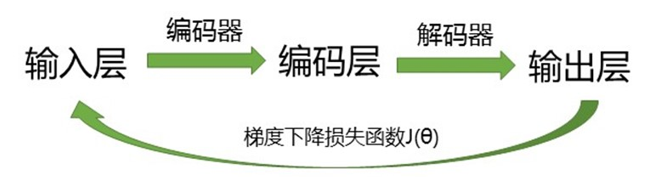

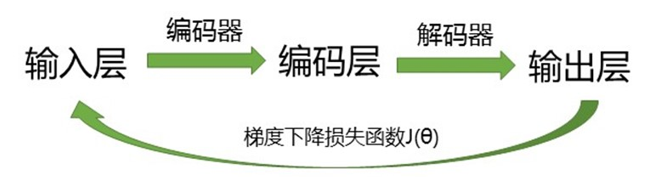

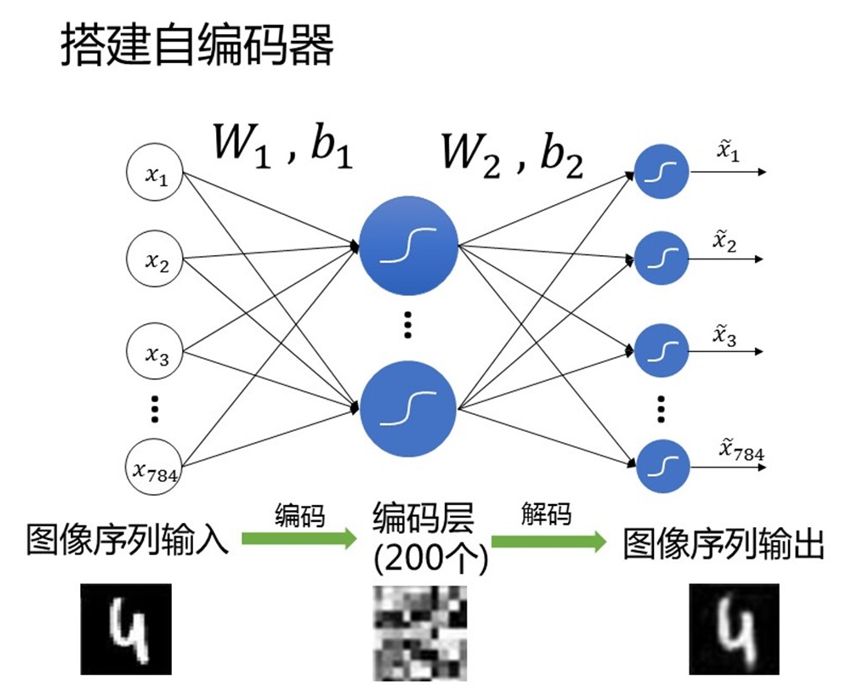

1986 年,Rumelhart 提出了自动编码器的概念,并将其用于高维复杂数据的处理,促进了神经网络的发展。自编码神经网络是一种无监督(自监督)学习算法,它使用了反向传播算法,并让目标值等于输入值,即自编码神经网络尝试学习一个 hW,b(x)≈x 的函数。

自编码器分类:

- 浅层自编码(Autoencoder)

- 稀疏自编码(Sparse Autoencoder)

- 栈式自编码(Stacked Autoencoder)

- 去噪自编码(Denoising Autoencoder)

- 变分自编码(Variational Autoencoder)

自编码器的共同点:学习一个与输入相同的输出,并尽可能的让其具有较强的泛化能力。

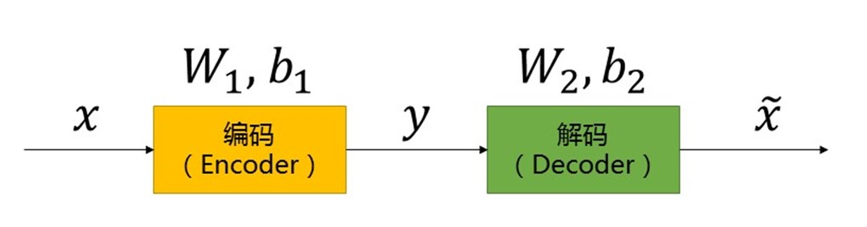

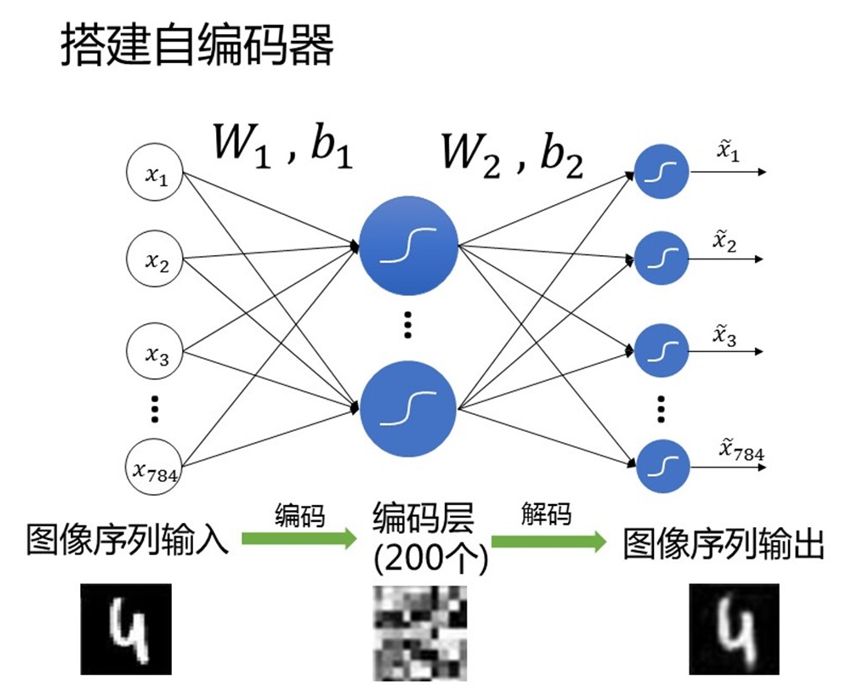

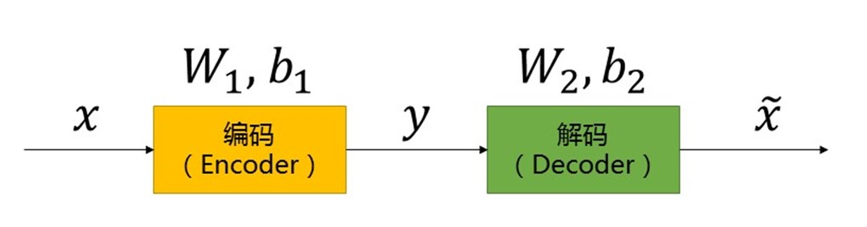

自编码器的构成:

编码器是把高维度数据有损的映射成低维度数据,减少数据量,要实现这种映射关系需要学习数据间的相关性,对输入 x 编码,得到新的特征 y:

y=f(W1x+b1)

解码器和编码器完全相反,是把低维度数据映射成高维度数据,增加数据量,使经过压缩的数据恢复成原来的样子,即利用新的特征 y,得到一个重构的数据 x′:

x′=g(W2y+b2)

损失函数用来衡量由于压缩而损失掉的信息。编码器和解码器一般都是参数化的方程,且关于损失函数可导,典型的情况是使用最小均方误差

MSE=n1i=1∑n(x−x′)2

来作为损失函数。

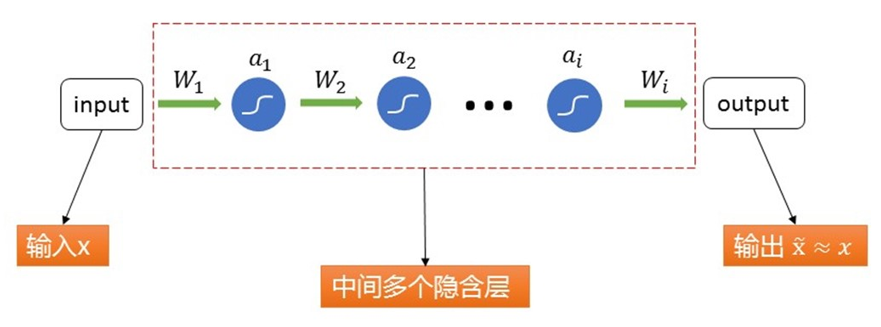

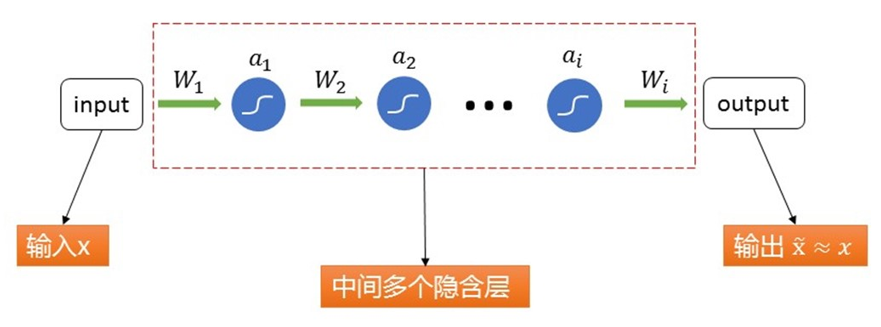

深度自编码器(DAE)

2006 年,Hinton 对原型自动编码器的结构进行了改进,进而产生了 DAE,先用无监督逐层贪心训练算法完成对隐含层的预训练,然后用反向传播算法对整个神经网络进行系统性参数优化调整,显著降低了神经网络的训练复杂程度,有效改善了反向传播算法容易陷入局部最小的不良状况。

将三层浅层自编码器扩展成具有多个隐藏层的编码器即为深度自编码器,能更好的学习数据更高维度的特征。

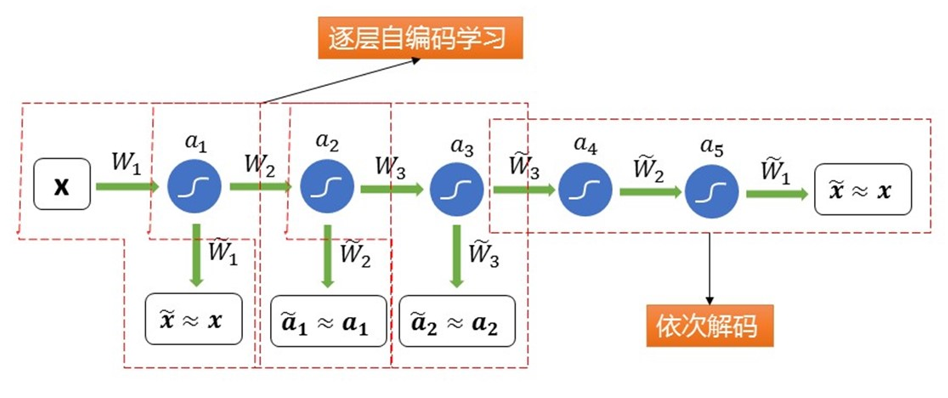

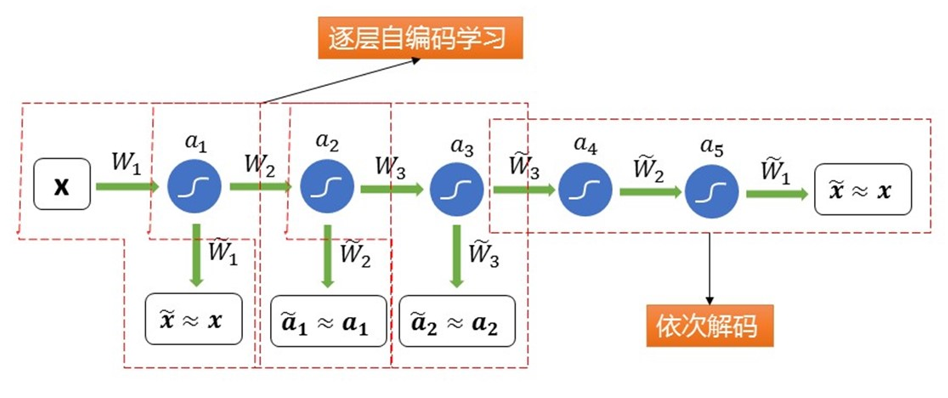

逐层学习

在深度自编码器中,对其中的多个隐藏层,我们需要进行逐层自编码学习。具体地,每一个编码层中都会包含一个解码器,用来输出当前层的解码结果,我们贪心地希望每一层的解码结果都与前一层向其输入的结果尽可能的相似,如下图所示:

深度自编码器特点:具有强大的表达能力及深度神经网络的所有优点。它通常能够获取到输入的“层次性分组”或者“部分-整体分解”结构。自编码器倾向于学习得到能更好地表示输入数据的特征。

稀疏表示和稀疏编码

稀疏表示

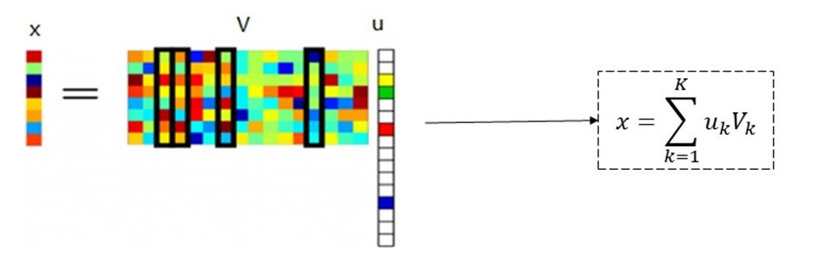

稀疏表示的目的是在给定的超完备字典中用尽可能少的原子来表示信号,可以获得信号更为简洁的表示方式,从而使我们更容易地获取信号中所蕴含的信息,更方便进一步对信号进行加工处理,如压缩、编码等。

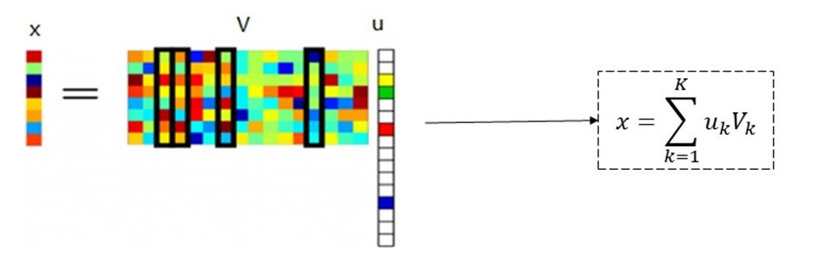

我们可以寻找一个系数矩阵 u 和一个字典矩阵 V,使得 V×u 尽可能的还原 x,且 u 尽可能地稀疏,则 u 就是 x 的稀疏表示。我们将一个大矩阵变成两个小矩阵,从而达到压缩的目的。

给定数据集 {x1,x2,…,xm},字典学习的最简单形式为

J(B,α)=B,αimini=1∑m∥xi−Bαi∥22+λi=1∑m∥αi∥1

其中 B∈Rd×k 为字典矩阵,k 称为字典的词汇量,通常由用户指定。αi∈Rk 则是样本 xi∈Rd 的稀疏表示。显然,上式的第一项是希望 αi 能较好地重构 xi,第二项则是希望 αi 尽量稀疏,可以再加入一项 +β∑r∑cBrc2,表示希望字典中每项也尽可能小。

为了较为简单的最小化上述二元函数,我们通过变量交替优化的策略来进行:

- 首先随机初始化字典矩阵 B;

- 然后通过梯度下降,得到 B 确定时使得函数 J(⋅,⋅) 取得最小值时的 α;

- 再通过梯度下降,得到 α 确定时使得函数 J(⋅,⋅) 取得最小值时的 B;

- 不断重复上述两步,直至结果确定。

稀疏自编码

一个神经网络的稀疏性可以被简单的解释为,这里假设神经元的激活函数为 sigmoid 函数,则当神经元的输出接近为 1 时,我们认为它是被激活的;而当其接近为 0 时,我们认为它是被抑制的。那么一个神经网络中,使得神经元在大部分的时间内都是被抑制的限制称为稀疏性限制。

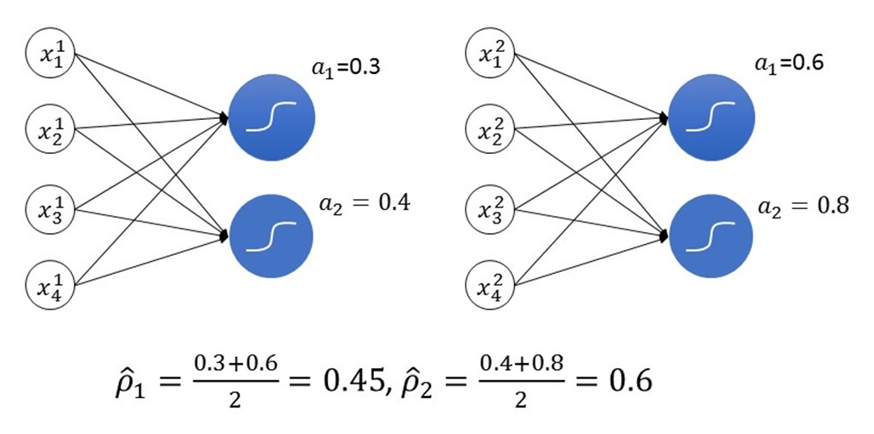

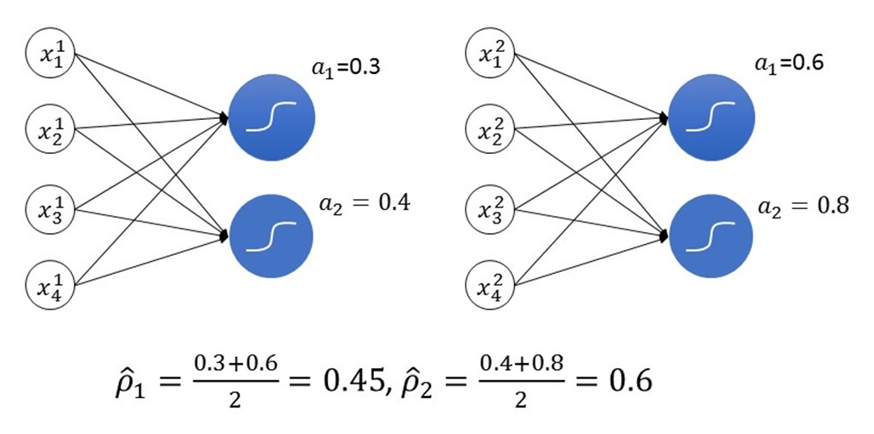

考虑一个最简单的自编码器,其神经网络只有三层,那么 aj(2) 表示隐藏层中的隐藏神经元 j 的激活值,但这种表示方法无法表示是哪一个输入 x 带来的激活值,所以我们改用 aj(2)(x) 表示在给定输入为 x 的情况下,隐藏层中的隐藏神经元 j 的激活值。

令

ρ^j=m1i=1∑maj(2)(x(i))

表示隐藏神经元 j 在 m 个输入样本上的平均激活度,举例如下:

我们可以近似的加入一条限制:ρ^j=ρ,其中 ρ 被称为稀疏性参数,通常是一个接近 0 的较小的值,如 0.05。

为了满足这一限制,将会在优化目标函数中加入一个惩罚因子,这将惩罚那些 ρ^j 和 ρ 有显著不同的情况,从而使得隐藏神经元的平均活跃度保持在较小范围内。

定义两分布 P,Q 之间的相对熵(KL 散度)为

D(P∥Q)=x∑E[lnp(x)−lnq(x)]=x∑p(x)lnq(x)p(x)

其中 p(x),q(x) 为两分布的概率密度函数。相对熵可以解释为“通过 q 的编码去编码 p后,信息丢失数的期望”,可以用相对熵来表示两个分布之间的差异。

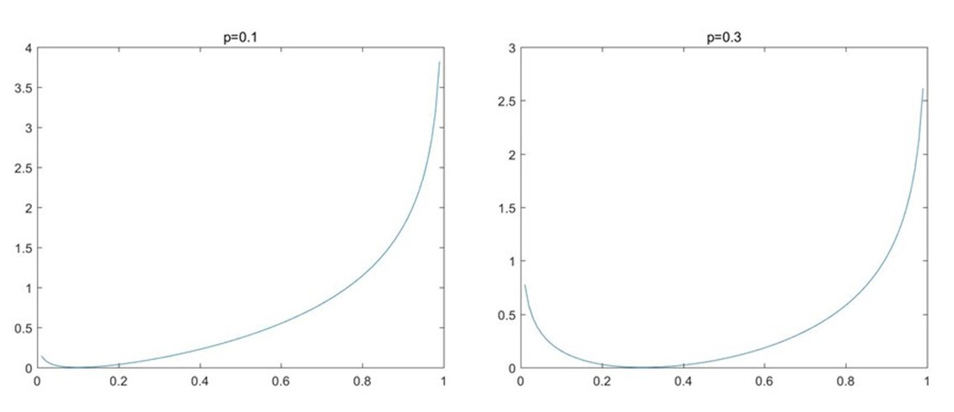

把隐层的每个神经元的激活和未激活态看做服从二项分布,则 KL 散度可以表示为一个以 ρ 为均值和一个以 ρ^j 为均值的两个二项分布之间的相对熵:

KL(ρ∥ρ^j)=ρlnρ^jρ+(1−ρ)ln1−ρ^j1−ρ

KL 散度有两个特点:

- KL(ρ∥ρ^j)≥0,当且仅当 ρ=ρ^j 时取等号;

- 非对称性:KL(ρ∥ρ^j)=KL(ρ^j∥ρ)。

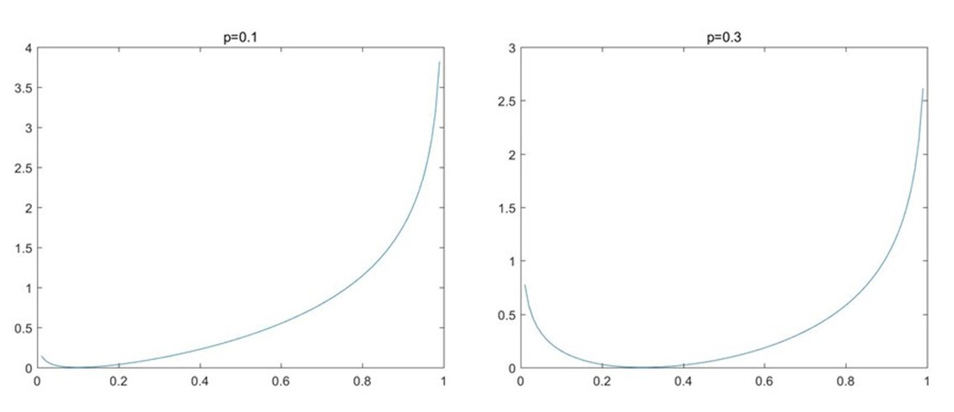

下面是 ρ=0.1 和 ρ=0.3 时 KL 散度的图像:

可以发现,当 ρ^j→0 or 1 时,KL(ρ∥ρ^j)→∞,这很好的惩罚了二者有显著不同的情况。

现在,总体的代价函数可以表示为

Jsparse(B,α)=J(B,α)+βj=1∑s2KL(ρ∥ρ^j)

注意到

∂ρ^j∂KL(ρ∥ρ^j)=−ρ^jρ+1−ρ^j1−ρ

于是在神经网络的反向传播中,当前层误差 δ(l) 更新为

δ(l)=((ω(l+1))Tδ(l+1)+β(−ρ^jρ+1−ρ^j1−ρ))⊙g′(z(l))

即可,其中 l=nl−1,nl−2,…,2。

注意,在进行稀疏自编码器的训练过程中,必须要先进行一次前向传播以得到所有神经元的平均激活度 ρ^。